Возможно, ваш любимый чат-бот с искусственным интеллектом говорит неправду

Поисковые инструменты с искусственным интеллектом становятся все более популярными, и каждый четвертый американец сообщает, что использует искусственный интеллект вместо традиционных поисковых систем. Однако, вот важное замечание: эти чат-боты с искусственным интеллектом не всегда предоставляют точную информацию.

Недавнее исследование Центра цифровой журналистики Tow, опубликованное Columbia Journalism Review, показывает, что чат-ботам трудно находить и точно цитировать новостной контент. Еще большее беспокойство вызывает их склонность выдумывать информацию, когда у них нет правильного ответа.

Чат-боты с искусственным интеллектом, протестированные для участия в опросе, включали в себя многие из “лучших”, в том числе ChatGPT, Perplexity, Perplexity Pro, DeepSeek, Microsoft Copilot, Grok-2, Grok-3 и Google Gemini.

В ходе тестирования чат-ботам с искусственным интеллектом были предоставлены прямые выдержки из 10 онлайн-статей, опубликованных различными изданиями. Каждый чат-бот получил 200 запросов, представляющих 10 статей от 20 различных издательств, на 1600 запросов. Чат-ботам было предложено указать заголовок каждой статьи, ее оригинального издателя, дату публикации и URL-адрес.

Аналогичные тесты, проведенные с использованием традиционных поисковых систем, успешно предоставили правильную информацию. Однако чат-боты с искусственным интеллектом показали себя не так хорошо.

Результаты показали, что чат-боты часто пытаются отклонить вопросы, на которые они не могут дать точный ответ, и часто вместо этого дают неверные или спекулятивные ответы. Чат-боты премиум-класса, как правило, дают заведомо неверные ответы чаще, чем их бесплатные аналоги. Кроме того, многие чат-боты, по-видимому, игнорируют настройки протокола исключения роботов (REP), который веб-сайты используют для взаимодействия с веб-роботами, такими как поисковые роботы.

Опрос также показал, что инструменты генерирующего поиска склонны к созданию ссылок и цитированию синдицированных или скопированных версий статей. Более того, соглашения о лицензировании контента с новостными источниками не гарантировали точного цитирования в ответах чат-ботов.

Что вы можете сделать?

Что особенно бросается в глаза в результатах этого опроса, так это не только то, что чат-боты с искусственным интеллектом часто предоставляют неверную информацию, но и то, что они делают это с пугающей уверенностью. Вместо того чтобы признать, что они не знают ответа, они склонны отвечать такими фразами, как “похоже”, “это возможно” или “могло бы быть”.

Например, ChatGPT неправильно определил 134 статьи, но только в 15 случаях из 200 ответов указал на неопределенность и ни разу не воздержался от ответа.

Исходя из результатов опроса, вероятно, разумно не полагаться исключительно на чат-ботов с искусственным интеллектом в поисках ответов. Вместо этого рекомендуется сочетание традиционных методов поиска и инструментов искусственного интеллекта. По крайней мере, использование нескольких чат-ботов с искусственным интеллектом для поиска ответа может оказаться полезным. В противном случае вы рискуете получить неверную информацию.

Забегая вперед, я бы не удивился, если бы увидел консолидацию чат-ботов с искусственным интеллектом, поскольку лучшие из них отличаются от некачественных. В конечном счете, их результаты будут такими же точными, как у традиционных поисковых систем. Когда это произойдет, остается только гадать.

Другие статьи

Китайский GAC будет продавать автомобили с автономным управлением третьего уровня совместно с Huawei

Запуск модельного ряда Xiangwang - это последний шаг компании GAC, давнего китайского партнера Toyota и Honda, в преодолении конкурентной среды.

Китайский GAC будет продавать автомобили с автономным управлением третьего уровня совместно с Huawei

Запуск модельного ряда Xiangwang - это последний шаг компании GAC, давнего китайского партнера Toyota и Honda, в преодолении конкурентной среды.

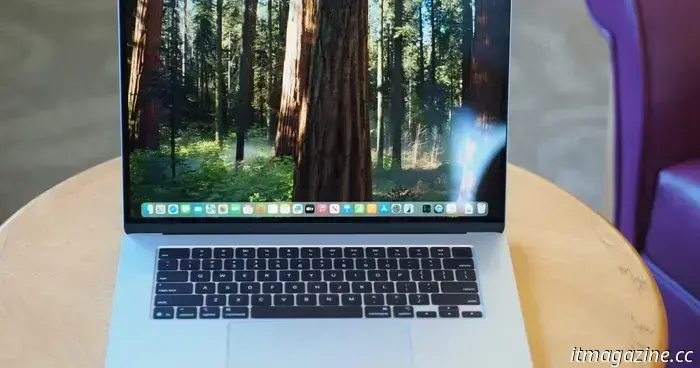

Благодаря чипсету Apple M4 MacBook Air 13 стал лучшим маленьким ноутбуком в мире

Модель Apple MacBook Air 13 M4 получила высокую оценку как лучший 13-дюймовый (или 14-дюймовый) ноутбук, который вы можете купить сегодня. А его базовая модель стала еще лучше, чем когда-либо.

Благодаря чипсету Apple M4 MacBook Air 13 стал лучшим маленьким ноутбуком в мире

Модель Apple MacBook Air 13 M4 получила высокую оценку как лучший 13-дюймовый (или 14-дюймовый) ноутбук, который вы можете купить сегодня. А его базовая модель стала еще лучше, чем когда-либо.

Mac Studio 2025 - это чистая, хотя и сбивающая с толку, магия производительности

Apple Mac Studio 2025 года выпуска повышает производительность и цену благодаря опциям M4 Max и M3 Ultra, которые упрощают процесс принятия решений.

Mac Studio 2025 - это чистая, хотя и сбивающая с толку, магия производительности

Apple Mac Studio 2025 года выпуска повышает производительность и цену благодаря опциям M4 Max и M3 Ultra, которые упрощают процесс принятия решений.

Нью-Йоркский мини-кроссворд сегодня: ответы на головоломки во вторник, 11 марта

Мини-кроссворд NYT может быть намного меньше обычного кроссворда, но это непросто. Если вы застряли с сегодняшним кроссвордом, у нас есть ответы для вас.

Нью-Йоркский мини-кроссворд сегодня: ответы на головоломки во вторник, 11 марта

Мини-кроссворд NYT может быть намного меньше обычного кроссворда, но это непросто. Если вы застряли с сегодняшним кроссвордом, у нас есть ответы для вас.

Вместо Disco Elysium 2, ZA/UM выпускает совершенно новую шпионскую игру

Следующая игра ZA/ UM - это не Disco Elysium 2, это совершенно новая шпионская игра под названием C4.

Вместо Disco Elysium 2, ZA/UM выпускает совершенно новую шпионскую игру

Следующая игра ZA/ UM - это не Disco Elysium 2, это совершенно новая шпионская игра под названием C4.

Возможно, ваш любимый чат-бот с искусственным интеллектом говорит неправду

Чат-боты с искусственным интеллектом не так умны, как можно было бы ожидать. На самом деле, иногда они ничего не знают и дают неверные ответы.