Il tuo chatbot preferito potrebbe non dire la verità

Gli strumenti di ricerca AI stanno diventando sempre più popolari, con un americano su quattro che riferisce di utilizzare l'intelligenza artificiale invece dei tradizionali motori di ricerca. Tuttavia, ecco una nota importante: questi chatbot AI non sempre forniscono informazioni accurate.

Un recente studio del Tow Center for Digital Journalism, riportato dalla Columbia Journalism Review, indica che i chatbot faticano a recuperare e citare accuratamente i contenuti delle notizie. Ancora più preoccupante è la loro tendenza a inventare informazioni quando non hanno la risposta corretta.

I chatbot AI testati per il sondaggio includevano molti dei "migliori", tra cui ChatGPT, Perplessità, Perplessità Pro, DeepSeek, Copilot di Microsoft, Grok-2, Grok-3 e Google Gemini.

Nei test, AI chatbot sono stati dati estratti diretti da 10 articoli online pubblicati da vari punti vendita. Ogni chatbot ha ricevuto 200 query, che rappresentano 10 articoli di 20 diversi editori, per 1.600 query. Ai chatbot è stato chiesto di identificare il titolo di ogni articolo, il suo editore originale, la data di pubblicazione e l'URL.

Test simili condotti con i motori di ricerca tradizionali hanno fornito con successo le informazioni corrette. Tuttavia, i chatbot AI non hanno funzionato altrettanto bene.

I risultati hanno indicato che i chatbot spesso lottano per rifiutare le domande a cui non possono rispondere con precisione, fornendo spesso risposte errate o speculative. I chatbot premium tendono a fornire risposte errate con sicurezza più spesso delle loro controparti gratuite. Inoltre, molti chatbot sembrano ignorare le preferenze del Robot Exclusion Protocol (REP), che i siti Web utilizzano per comunicare con i robot Web come i crawler dei motori di ricerca.

L'indagine ha anche rilevato che gli strumenti di ricerca generativa erano inclini a fabbricare collegamenti e citare versioni di articoli sindacati o copiati. Inoltre, gli accordi di licenza dei contenuti con le fonti di notizie non garantivano citazioni accurate nelle risposte dei chatbot.

Cosa puoi fare?

Ciò che spicca di più sui risultati di questo sondaggio non è solo il fatto che i chatbot AI spesso forniscono informazioni errate, ma che lo fanno con sicurezza allarmante. Invece di ammettere di non conoscere la risposta, tendono a rispondere con frasi come “sembra”, “è possibile” o “potrebbe.”

Ad esempio, ChatGPT ha identificato erroneamente 134 articoli, ma ha segnalato incertezza solo 15 volte su 200 risposte e non si è mai astenuto dal fornire una risposta.

Sulla base dei risultati del sondaggio, è probabilmente saggio non fare affidamento esclusivamente sui chatbot AI per le risposte. Invece, si consiglia una combinazione di metodi di ricerca tradizionali e strumenti AI. Per lo meno, l'utilizzo di più chatbot AI per trovare una risposta può essere utile. Altrimenti, rischi di ottenere informazioni errate.

Guardando al futuro, non sarei sorpreso di vedere un consolidamento dei chatbot AI in quanto quelli migliori si distinguono da quelli di scarsa qualità. Alla fine, i loro risultati saranno accurati come quelli dei motori di ricerca tradizionali. Quando questo accadrà è l'ipotesi di chiunque.

Altri articoli

Fluance punta sugli audiofili attenti ai costi con due nuovi diffusori della serie Reference

I produttori canadesi di apparecchiature audio Fluance hanno annunciato i suoi diffusori Ri71 bookshelf e Ri91 tower, entrambi diffusori di riferimento ad alta fedeltà a buon prezzo con in mente gli audiofili in erba.

Fluance punta sugli audiofili attenti ai costi con due nuovi diffusori della serie Reference

I produttori canadesi di apparecchiature audio Fluance hanno annunciato i suoi diffusori Ri71 bookshelf e Ri91 tower, entrambi diffusori di riferimento ad alta fedeltà a buon prezzo con in mente gli audiofili in erba.

Invece di Disco Elysium 2, ZA / UM sta facendo un nuovo gioco di spionaggio

Il prossimo gioco di ZA/UM non è Disco Elysium 2; è un nuovo gioco di spionaggio chiamato C4.

Invece di Disco Elysium 2, ZA / UM sta facendo un nuovo gioco di spionaggio

Il prossimo gioco di ZA/UM non è Disco Elysium 2; è un nuovo gioco di spionaggio chiamato C4.

NYT Strands oggi: suggerimenti, spangram e risposte per martedì 11 marzo

Strands è una versione difficile della classica ricerca di parole di NYT Games. Se sei bloccato e non riesci a risolvere il puzzle di oggi, abbiamo aiuto e suggerimenti per te qui.

NYT Strands oggi: suggerimenti, spangram e risposte per martedì 11 marzo

Strands è una versione difficile della classica ricerca di parole di NYT Games. Se sei bloccato e non riesci a risolvere il puzzle di oggi, abbiamo aiuto e suggerimenti per te qui.

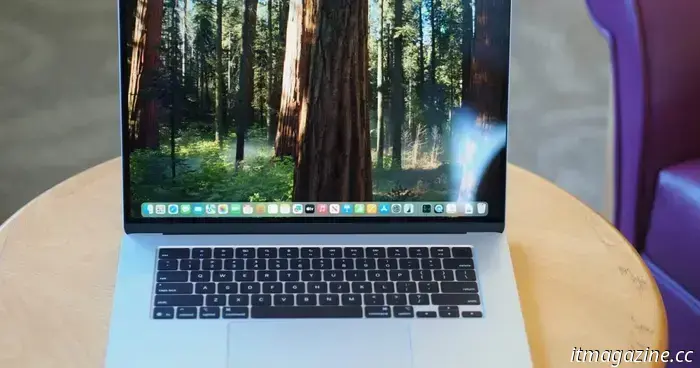

Il chipset M4 di Apple trasforma il MacBook Air 15 in un laptop quasi perfetto

L'Apple MacBook Air 15 M4 aggiunge un sacco di potenza e un'efficienza ancora migliore per rendere il miglior laptop da 15 pollici sottile e leggero che puoi acquistare oggi.

Il chipset M4 di Apple trasforma il MacBook Air 15 in un laptop quasi perfetto

L'Apple MacBook Air 15 M4 aggiunge un sacco di potenza e un'efficienza ancora migliore per rendere il miglior laptop da 15 pollici sottile e leggero che puoi acquistare oggi.

Il prossimo aggiornamento di iOS potrebbe costringerti ad aggiornare Apple Home

Il prossimo aggiornamento di iOS potrebbe costringere gli utenti di HomeKit ad aggiornare l'ultima architettura dell'app domestica o perdere il supporto, secondo il codice scoperto nella beta di iOS 18.4.

Il prossimo aggiornamento di iOS potrebbe costringerti ad aggiornare Apple Home

Il prossimo aggiornamento di iOS potrebbe costringere gli utenti di HomeKit ad aggiornare l'ultima architettura dell'app domestica o perdere il supporto, secondo il codice scoperto nella beta di iOS 18.4.

Cosa ha causato l'interruzione X che Musk sta incolpando l'Ucraina?

Elon Musk ha detto che le interruzioni di X sono state causate da un attacco informatico in Ucraina. Gli esperti hanno incolpato le botnet, ma i colpevoli saranno difficili da trovare.

Cosa ha causato l'interruzione X che Musk sta incolpando l'Ucraina?

Elon Musk ha detto che le interruzioni di X sono state causate da un attacco informatico in Ucraina. Gli esperti hanno incolpato le botnet, ma i colpevoli saranno difficili da trovare.

Il tuo chatbot preferito potrebbe non dire la verità

I chatbot AI non sono così intelligenti come ci si potrebbe aspettare. In effetti, a volte non sanno nulla e forniscono risposte errate.