Es posible que su chatbot de IA favorito no esté diciendo la verdad

Las herramientas de búsqueda de IA se están volviendo más populares, y uno de cada cuatro estadounidenses informa que usa IA en lugar de los motores de búsqueda tradicionales. Sin embargo, aquí hay una nota importante: estos chatbots de IA no siempre brindan información precisa.

Un estudio reciente del Centro Tow para el Periodismo Digital, reportado por Columbia Journalism Review, indica que los chatbots tienen dificultades para recuperar y citar contenido de noticias con precisión. Aún más preocupante es su tendencia a inventar información cuando no tienen la respuesta correcta.

Los chatbots de IA probados para la encuesta incluyeron muchos de los "mejores", incluidos ChatGPT, Perplexity, Perplexity Pro, DeepSeek, Copilot de Microsoft, Grok-2, Grok-3 y Google Gemini.

En las pruebas, los chatbots de IA recibieron extractos directos de 10 artículos en línea publicados por varios medios. Cada chatbot recibió 200 consultas, que representaban 10 artículos de 20 editores diferentes, para 1600 consultas. Se les pidió a los chatbots que identificaran el título de cada artículo, su editor original, fecha de publicación y URL.

Pruebas similares realizadas con motores de búsqueda tradicionales proporcionaron con éxito la información correcta. Sin embargo, los chatbots de IA no funcionaron tan bien.

Los hallazgos indicaron que los chatbots a menudo tienen dificultades para rechazar preguntas que no pueden responder con precisión, proporcionando con frecuencia respuestas incorrectas o especulativas. Los chatbots premium tienden a ofrecer respuestas incorrectas con más frecuencia que sus contrapartes gratuitas. Además, muchos chatbots parecían ignorar las preferencias del Protocolo de Exclusión de Robots (REP), que los sitios web utilizan para comunicarse con robots web como los rastreadores de motores de búsqueda.

La encuesta también encontró que las herramientas de búsqueda generativa eran propensas a fabricar enlaces y citar versiones sindicadas o copiadas de artículos. Además, los acuerdos de licencia de contenido con fuentes de noticias no garantizaban citas precisas en las respuestas del chatbot.

¿Qué puedes hacer?

Lo que más destaca de los resultados de esta encuesta no es solo que los chatbots de IA a menudo brindan información incorrecta, sino que lo hacen con una confianza alarmante. En lugar de admitir que no saben la respuesta, tienden a responder con frases como "parece", "es posible" o "podría".”

Por ejemplo, ChatGPT identificó incorrectamente 134 artículos, pero solo señaló incertidumbre 15 veces de 200 respuestas y nunca se abstuvo de dar una respuesta.

Según los resultados de la encuesta, probablemente sea aconsejable no depender exclusivamente de los chatbots de IA para obtener respuestas. En cambio, se recomienda una combinación de métodos de búsqueda tradicionales y herramientas de IA. Como mínimo, usar múltiples chatbots de IA para encontrar una respuesta puede ser beneficioso. De lo contrario, corre el riesgo de obtener información incorrecta.

De cara al futuro, no me sorprendería ver una consolidación de los chatbots de IA a medida que los mejores se destaquen de los de baja calidad. Eventualmente, sus resultados serán tan precisos como los de los motores de búsqueda tradicionales. Cuándo sucederá eso es una incógnita.

Otros artículos

En lugar de Disco Elysium 2, ZA / UM está haciendo un nuevo juego de espionaje

El próximo juego de ZA/UM no es Disco Elysium 2; es un nuevo juego de espionaje llamado C4.

En lugar de Disco Elysium 2, ZA / UM está haciendo un nuevo juego de espionaje

El próximo juego de ZA/UM no es Disco Elysium 2; es un nuevo juego de espionaje llamado C4.

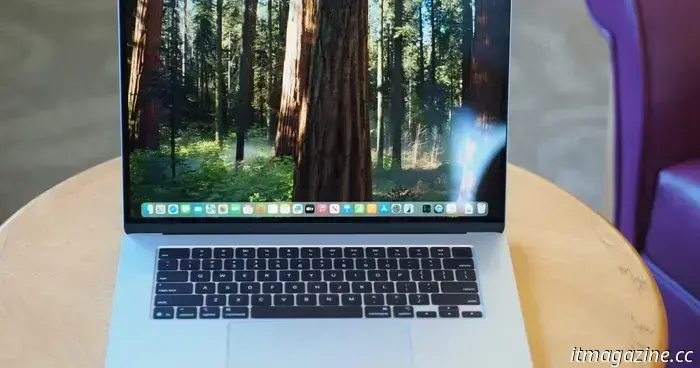

Con el chipset Apple M4, la MacBook Air 13 es ahora la mejor computadora portátil pequeña de la historia

El modelo Apple MacBook Air 13 M4 ahora obtiene una puntuación perfecta, como la mejor computadora portátil de 13 pulgadas (o 14 pulgadas) que puede comprar hoy. Y su modelo base es mejor que nunca.

Con el chipset Apple M4, la MacBook Air 13 es ahora la mejor computadora portátil pequeña de la historia

El modelo Apple MacBook Air 13 M4 ahora obtiene una puntuación perfecta, como la mejor computadora portátil de 13 pulgadas (o 14 pulgadas) que puede comprar hoy. Y su modelo base es mejor que nunca.

La próxima actualización de iOS podría obligarte a actualizar Apple Home

La próxima actualización de iOS podría obligar a los usuarios de HomeKit a actualizar a la última arquitectura de la aplicación Home o perder soporte, según el código descubierto en la versión beta de iOS 18.4.

La próxima actualización de iOS podría obligarte a actualizar Apple Home

La próxima actualización de iOS podría obligar a los usuarios de HomeKit a actualizar a la última arquitectura de la aplicación Home o perder soporte, según el código descubierto en la versión beta de iOS 18.4.

¿Qué causó la interrupción X de la que Musk culpa a Ucrania?

Elon Musk dijo que las interrupciones en X fueron causadas por un ciberataque en Ucrania. Los expertos culparon a las botnets, pero será difícil encontrar a los culpables.

¿Qué causó la interrupción X de la que Musk culpa a Ucrania?

Elon Musk dijo que las interrupciones en X fueron causadas por un ciberataque en Ucrania. Los expertos culparon a las botnets, pero será difícil encontrar a los culpables.

El GAC de China venderá vehículos de conducción autónoma de nivel 3 con Huawei

El lanzamiento de la línea Xiangwang es el último paso de GAC, un socio chino de Toyota y Honda desde hace mucho tiempo, para navegar por un panorama competitivo.

El GAC de China venderá vehículos de conducción autónoma de nivel 3 con Huawei

El lanzamiento de la línea Xiangwang es el último paso de GAC, un socio chino de Toyota y Honda desde hace mucho tiempo, para navegar por un panorama competitivo.

Es posible que su chatbot de IA favorito no esté diciendo la verdad

Los chatbots de IA no son tan inteligentes como cabría esperar. De hecho, a veces no saben nada y dan respuestas incorrectas.