Non è la tua immaginazione — I modelli ChatGPT in realtà fanno allucinazioni di più ora

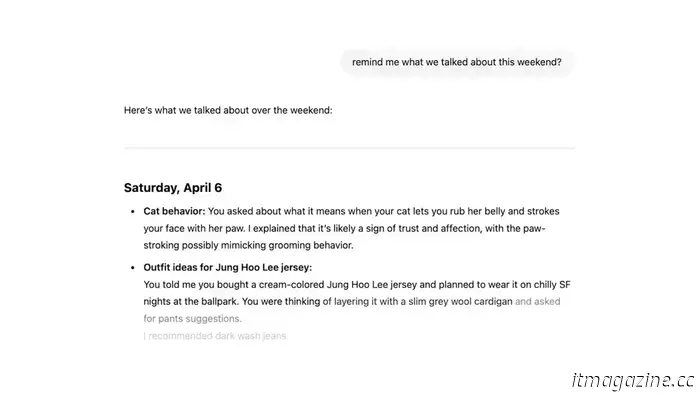

OpenAI ha pubblicato un documento la scorsa settimana in dettaglio vari test interni e risultati sui suoi modelli o3 e o4-mini. Le principali differenze tra questi modelli più recenti e le prime versioni di ChatGPT che abbiamo visto nel 2023 sono il loro ragionamento avanzato e le capacità multimodali. o3 e o4-mini possono generare immagini, cercare sul Web, automatizzare attività, ricordare vecchie conversazioni e risolvere problemi complessi. Tuttavia, sembra che questi miglioramenti abbiano anche portato effetti collaterali inaspettati.

Cosa dicono i test?

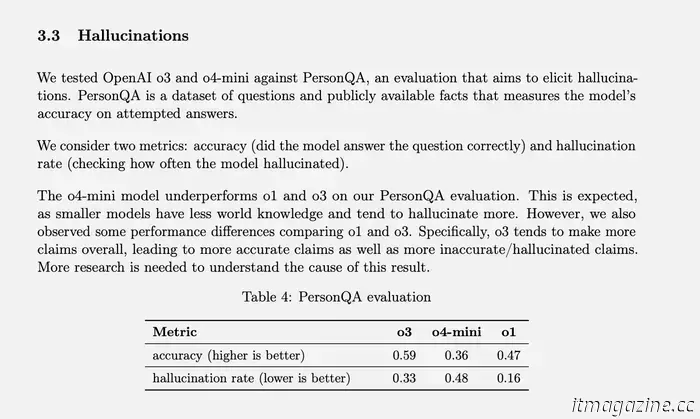

OpenAI ha un test specifico per misurare i tassi di allucinazione chiamato PersonQA. Include una serie di fatti sulle persone da cui “imparare” e una serie di domande su quelle persone a cui rispondere. La precisione del modello viene misurata in base ai suoi tentativi di risposta. Il modello o1 dello scorso anno ha raggiunto un tasso di accuratezza del 47% e un tasso di allucinazione del 16%.

Dal momento che questi due valori non si sommano al 100%, possiamo supporre che il resto delle risposte non siano state né accurate né allucinazioni. Il modello potrebbe a volte dire che non sa o non può individuare le informazioni, potrebbe non fare alcuna rivendicazione e fornire informazioni correlate, oppure potrebbe commettere un piccolo errore che non può essere classificato come un'allucinazione completa.

OpenAI

Quando o3 e o4-mini sono stati testati contro questa valutazione, hanno allucinato ad un tasso significativamente più alto di o1. Secondo OpenAI, questo era in qualche modo previsto per il modello o4-mini perché è più piccolo e ha meno conoscenza del mondo, portando a più allucinazioni. Tuttavia, il tasso di allucinazione del 48% raggiunto sembra molto alto considerando che o4-mini è un prodotto disponibile in commercio che le persone utilizzano per cercare sul Web e ottenere tutti i tipi di informazioni e consigli diversi.

o3, il modello a grandezza naturale, ha avuto allucinazioni sul 33% delle sue risposte durante il test, superando o4-mini ma raddoppiando il tasso di allucinazioni rispetto a o1. Aveva anche un alto tasso di precisione, tuttavia, che OpenAI attribuisce alla sua tendenza a fare più affermazioni nel complesso. Quindi, se usi uno di questi due modelli più recenti e hai notato molte allucinazioni, non è solo la tua immaginazione. (Forse dovrei fare una battuta lì come " Non ti preoccupare, non sei quello che ha le allucinazioni.”)

Cosa sono le "allucinazioni" dell'IA e perché accadono?

Mentre probabilmente hai già sentito parlare di modelli di intelligenza artificiale "allucinanti", non è sempre chiaro cosa significhi. Ogni volta che usi un prodotto AI, OpenAI o altro, sei praticamente garantito di vedere un disclaimer da qualche parte che dice che le sue risposte possono essere inaccurate e devi verificare di persona.

Informazioni imprecise possono provenire da tutto il luogo — a volte un fatto negativo arriva a Wikipedia o gli utenti beccano sciocchezze su Reddit, e questa disinformazione può trovare la sua strada nelle risposte AI. Ad esempio, le panoramiche AI di Google hanno attirato molta attenzione quando hanno suggerito una ricetta per la pizza che includeva " colla non tossica. Alla fine, si è scoperto che Google ha ottenuto queste "informazioni" da una battuta su un thread Reddit.

Tuttavia, queste non sono “allucinazioni", sono più simili a errori tracciabili che derivano da dati errati e interpretazioni errate. Le allucinazioni, d'altra parte, si verificano quando il modello di intelligenza artificiale fa un'affermazione senza alcuna fonte o ragione chiara. Accade spesso quando un modello di intelligenza artificiale non riesce a trovare le informazioni di cui ha bisogno per rispondere a una query specifica, e OpenAI lo ha definito come “una tendenza a inventare fatti in momenti di incertezza."Altre figure del settore lo hanno chiamato" creativo gap-riempimento.”

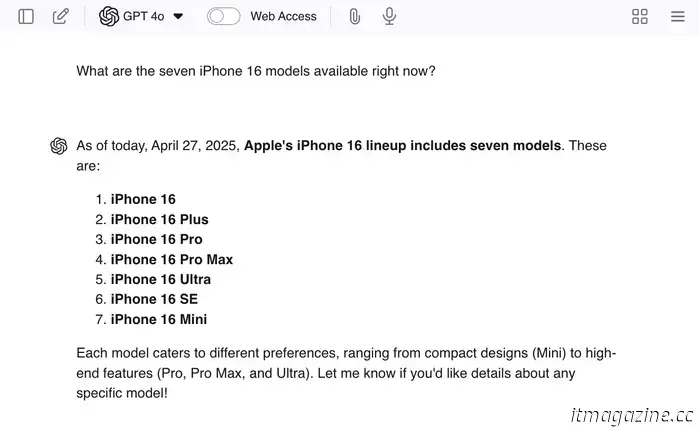

Puoi incoraggiare le allucinazioni dando a ChatGPT domande principali come " Quali sono i sette modelli di iPhone 16 disponibili in questo momento?"Dal momento che non ci sono sette modelli, l'LLM è in qualche modo in grado di darti alcune risposte reali — e quindi creare modelli aggiuntivi per finire il lavoro.

Ho deciso di inserire il mio esempio in GPT 4o nel caso in cui ci sarebbe davvero caduto — e lo ha fatto! Willow Roberts / Tendenze digitali

I chatbot come ChatGPT non sono solo addestrati sui dati di Internet che informano il contenuto delle loro risposte, ma sono anche addestrati su “come rispondere”. Vengono mostrate migliaia di query di esempio e corrispondenti risposte ideali per incoraggiare il giusto tipo di tono, atteggiamento e livello di cortesia.

Questa parte del processo di formazione è ciò che fa sì che un LLM suoni come se fosse d'accordo con te o capisse cosa stai dicendo anche se il resto del suo output contraddice completamente quelle affermazioni. È possibile che questo allenamento possa essere parte del motivo per cui le allucinazioni sono così frequenti-perché una risposta sicura che risponde alla domanda è stata rafforzata come un risultato più favorevole rispetto a una risposta che non riesce a rispondere alla domanda.

Per noi, sembra ovvio che sputare bugie casuali è peggio che non conoscere la risposta-ma gli LLM non mentono."Non sanno nemmeno cos'è una bugia. Alcune persone dicono che gli errori di intelligenza artificiale sono come gli errori umani, e dal momento che “non riusciamo a fare le cose bene tutto il tempo, non dovremmo aspettarci nemmeno l'intelligenza artificiale."Tuttavia, è importante ricordare che gli errori dell'IA sono semplicemente il risultato di processi imperfetti progettati da noi.

I modelli di intelligenza artificiale non mentono, sviluppano incomprensioni o ricordano erroneamente le informazioni come facciamo noi. Non hanno nemmeno concetti di accuratezza o inesattezza — semplicemente predicono la parola successiva in una frase in base alle probabilità. E dal momento che per fortuna siamo ancora in uno stato in cui la cosa più comunemente detta è probabile che sia la cosa corretta, quelle ricostruzioni spesso riflettono informazioni accurate. Ciò fa sembrare che quando otteniamo” la risposta giusta", è solo un effetto collaterale casuale piuttosto che un risultato che abbiamo progettato — ed è davvero così che funzionano le cose.

Alimentiamo l'intero valore di Internet di informazioni a questi modelli-ma non diciamo loro quali informazioni sono buone o cattive, accurate o inaccurate — non diciamo loro nulla. Non hanno conoscenze fondamentali esistenti o una serie di principi sottostanti per aiutarli a ordinare le informazioni per se stessi. È tutto solo un gioco di numeri: i modelli di parole che esistono più frequentemente in un dato contesto diventano la “verità " del LLM."Per me, questo suona come un sistema destinato a bloccarsi e bruciare-ma altri credono che questo sia il sistema che porterà ad AGI (anche se questa è una discussione diversa.)

Qual è la soluzione?

OpenAI

Il problema è che OpenAI non sa ancora perché questi modelli avanzati tendono ad avere allucinazioni più spesso. Forse con un po ' più di ricerca, saremo in grado di capire e risolvere il problema, ma c'è anche la possibilità che le cose non vadano così bene. La società continuerà senza dubbio a rilasciare modelli sempre più “avanzati”, e c'è la possibilità che i tassi di allucinazione continuino ad aumentare.

In questo caso, OpenAI potrebbe aver bisogno di perseguire una soluzione a breve termine e continuare la sua ricerca sulla causa principale. Dopotutto, questi modelli sono prodotti per fare soldi e devono essere in uno stato utilizzabile. Non sono uno scienziato dell'IA, ma suppongo che la mia prima idea sarebbe quella di creare una sorta di prodotto aggregato — un'interfaccia di chat che abbia accesso a più modelli OpenAI diversi.

Quando una query richiede un ragionamento avanzato, chiamerebbe GPT-4o e quando vuole ridurre al minimo le possibilità di allucinazioni, chiamerebbe un modello più vecchio come o1. Forse l'azienda sarebbe in grado di andare ancora più elaborato e utilizzare modelli diversi per prendersi cura di diversi elementi di una singola query, e quindi utilizzare un modello aggiuntivo per cucire tutto insieme alla fine. Dal momento che questo sarebbe essenzialmente un lavoro di squadra tra più modelli di intelligenza artificiale, forse potrebbe essere implementato anche un qualche tipo di sistema di controllo dei fatti.

Tuttavia, aumentare i tassi di precisione non è l'obiettivo principale. L'obiettivo principale è abbassare i tassi di allucinazione, il che significa che dobbiamo valutare le risposte che dicono “Non lo so” e le risposte con le risposte giuste.

In realtà, non ho idea di cosa farà OpenAI o di quanto siano preoccupati i suoi ricercatori per il crescente tasso di allucinazioni. Tutto quello che so è che più allucinazioni sono un male per gli utenti finali — significa solo sempre più opportunità per noi di essere ingannati senza rendersene conto. Se sei un grande appassionato di LLM, non c'è bisogno di smettere di usarli, ma non lasciare che il desiderio di risparmiare tempo vinca sulla necessità di verificare i risultati. Sempre fact-check!

Altri articoli

I migliori giradischi Bluetooth del 2025: giradischi wireless testati da noi

Non hai bisogno di costosi componenti per ascoltare il vinile. Puoi connetterti al tuo altoparlante wireless preferito con un giradischi Bluetooth. Questi sono i nostri preferiti.

I migliori giradischi Bluetooth del 2025: giradischi wireless testati da noi

Non hai bisogno di costosi componenti per ascoltare il vinile. Puoi connetterti al tuo altoparlante wireless preferito con un giradischi Bluetooth. Questi sono i nostri preferiti.

Hai chiesto: Nintendo Switch 2, i migliori telefoni Android e aggiornamenti OLED

Nell'episodio di oggi di You Asked, ci immergiamo in alcune delle tue domande tecniche scottanti, tra cui le ultime su Nintendo Switch 2, i telefoni Android consigliati e se valga la pena aggiornare il tuo TV OLED per un migliore rivestimento antiriflesso.

Hai chiesto: Nintendo Switch 2, i migliori telefoni Android e aggiornamenti OLED

Nell'episodio di oggi di You Asked, ci immergiamo in alcune delle tue domande tecniche scottanti, tra cui le ultime su Nintendo Switch 2, i telefoni Android consigliati e se valga la pena aggiornare il tuo TV OLED per un migliore rivestimento antiriflesso.

La risposta di Huawei al Moto Razr Ultra 2025 mi chiede chi ha ragione

I telefoni flip dovrebbero essere uno smartphone più piccolo o un tablet più piccolo? Ho trascorso del tempo con Huawei Pura X e Razr Ultra 2025 per rispondere a questa domanda esatta

La risposta di Huawei al Moto Razr Ultra 2025 mi chiede chi ha ragione

I telefoni flip dovrebbero essere uno smartphone più piccolo o un tablet più piccolo? Ho trascorso del tempo con Huawei Pura X e Razr Ultra 2025 per rispondere a questa domanda esatta

Ho usato un'app gratuita per risolvere il mio più grande problema con macOS

Apple non ha cotto una clipboard a livello di sistema in macOS. Maccy colma questa lacuna magnificamente, pur rimanendo open-source e totalmente gratuito, se lo vuoi.

Ho usato un'app gratuita per risolvere il mio più grande problema con macOS

Apple non ha cotto una clipboard a livello di sistema in macOS. Maccy colma questa lacuna magnificamente, pur rimanendo open-source e totalmente gratuito, se lo vuoi.

6 impostazioni di sicurezza che cambio sempre su un nuovo PC Windows

Queste sono le impostazioni di sicurezza di Windows 11 che cambio sempre il prima possibile.

6 impostazioni di sicurezza che cambio sempre su un nuovo PC Windows

Queste sono le impostazioni di sicurezza di Windows 11 che cambio sempre il prima possibile.

Non è la tua immaginazione — I modelli ChatGPT in realtà fanno allucinazioni di più ora

Secondo i test interni, i modelli più recenti come o3 e o4-mini allucinano significativamente più delle versioni precedenti, e OpenAI non sa perché.