La detección de deepfakes mejora al usar algoritmos más conscientes de la diversidad demográfica

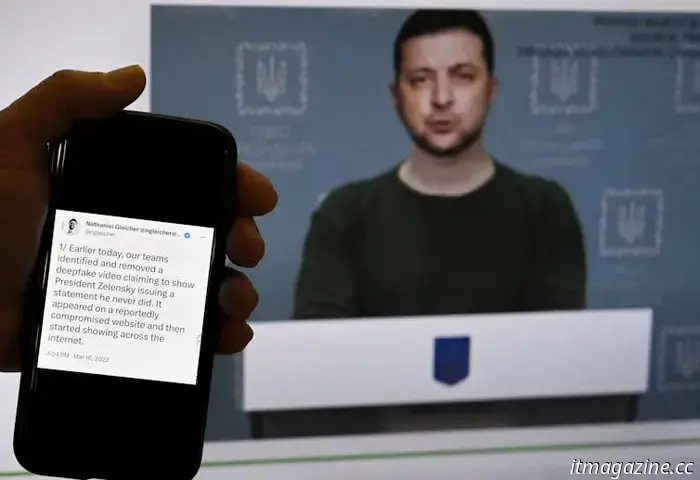

Los deepfakes -es decir, poner palabras en boca de otra persona de forma creíble- son cada vez más sofisticados y difíciles de detectar. Algunos ejemplos recientes de deepfakes son imágenes de Taylor Swift desnuda, una grabación de audio del presidente Joe Biden diciendo a los residentes de New Hampshire que no voten y un vídeo del presidente ucraniano Volodymyr Zelenskyy pidiendo a sus tropas que depongan las armas. Aunque las empresas han creado detectores para ayudar a detectar los deepfakes, los estudios han descubierto que los sesgos en los datos utilizados para entrenar estas herramientas pueden llevar a que ciertos grupos demográficos sean objeto de ataques injustos.

Un deepfake del presidente ucraniano Volodymyr Zelensky en 2022 en el que supuestamente pedía a sus tropas que depusieran las armas. Olivier Douliery/AFP via Getty Images Mi equipo y yo hemos descubierto nuevos métodos que mejoran tanto la imparcialidad como la precisión de los algoritmos utilizados para detectar deepfakes. Para ello, utilizamos un gran conjunto de datos de falsificaciones faciales que permite a investigadores como nosotros entrenar nuestros métodos de aprendizaje profundo. Nuestro trabajo se basó en el algoritmo de detección de última generación Xception, que es una base ampliamente utilizada para los sistemas de detección de deepfakes y puede detectar deepfakes con una precisión del 91,5%. Creamos dos métodos distintos de detección de deepfakes con el objetivo de fomentar la equidad. Uno se centraba en hacer que el algoritmo fuera más consciente de la diversidad demográfica etiquetando los conjuntos de datos por género y raza para minimizar los errores entre los grupos infrarrepresentados. El otro pretendía mejorar la equidad sin depender de las etiquetas demográficas, centrándose en su lugar en características no visibles para el ojo humano. Resultó que el primer método funcionó mejor. Aumentó los índices de precisión del 91,5% de referencia al 94,17%, lo que supuso un aumento mayor que nuestro segundo método y que otros que probamos. Creemos que la imparcialidad y la precisión son cruciales para que el público acepte la tecnología de inteligencia artificial. Cuando los grandes modelos lingüísticos como ChatGPT "alucinan", pueden perpetuar información errónea. Del mismo modo, las imágenes y vídeos falsos pueden socavar la adopción de la IA si no pueden detectarse con rapidez y precisión. Mejorar la equidad de estos algoritmos de detección para que no perjudiquen de forma desproporcionada a determinados grupos demográficos es un aspecto clave para ello. Nuestra investigación aborda la equidad de los algoritmos de detección de deepfakes, en lugar de limitarse a intentar equilibrar los datos. Ofrece un nuevo enfoque para el diseño de algoritmos que tiene en cuenta la equidad demográfica como un aspecto central. Siwei Lyu, Profesor de Ciencias de la Computación e Ingeniería; Director, UB Media Forensic Lab, Universidad de Buffalo y Yan Ju, Candidato a Doctor en Ciencias de la Computación e Ingeniería, Universidad de Buffalo Este artículo ha sido republicado de The Conversation bajo una licencia Creative Commons. Lee el artículo original. Recibe el boletín de TNW Recibe las noticias tecnológicas más importantes en tu bandeja de entrada cada semana. También etiquetado con

Otros artículos

¿Revolucionará la IA el desarrollo de fármacos? Los investigadores dicen que depende de cómo se utilice

Un alto índice de fracaso farmacológico es algo más que un problema de reconocimiento de patrones. He aquí cómo podemos abordar algunas de las causas profundas.

¿Revolucionará la IA el desarrollo de fármacos? Los investigadores dicen que depende de cómo se utilice

Un alto índice de fracaso farmacológico es algo más que un problema de reconocimiento de patrones. He aquí cómo podemos abordar algunas de las causas profundas.

ASUS Zenfone 12 Ultra: Todo lo que sabemos

El Asus Zenfone 12 Ultra está a la vuelta de la esquina. Aquí está todo lo que sabemos sobre el teléfono hasta ahora.

ASUS Zenfone 12 Ultra: Todo lo que sabemos

El Asus Zenfone 12 Ultra está a la vuelta de la esquina. Aquí está todo lo que sabemos sobre el teléfono hasta ahora.

El último vuelo del cohete de Blue Origin incluyó una experiencia similar a la lunar

Por primera vez, la empresa de vuelos espaciales dirigida por Jeff Bezos simuló la gravedad lunar en un cohete suborbital para probar varias cargas útiles científicas.

El último vuelo del cohete de Blue Origin incluyó una experiencia similar a la lunar

Por primera vez, la empresa de vuelos espaciales dirigida por Jeff Bezos simuló la gravedad lunar en un cohete suborbital para probar varias cargas útiles científicas.

.jpg) Las mejores películas gratis en YouTube ahora mismo (enero 2025)

Dodgeball, La proposición, La primera vez y Point Break son algunas de las mejores películas gratis en YouTube este mes.

Las mejores películas gratis en YouTube ahora mismo (enero 2025)

Dodgeball, La proposición, La primera vez y Point Break son algunas de las mejores películas gratis en YouTube este mes.

La NBA prueba un nuevo balón de baloncesto inteligente fabricado en Europa

La NBA está experimentando con un balón de baloncesto inteligente fabricado por SportIQ, una startup finlandesa que desarrolla sistemas de sensores para el deporte.

La NBA prueba un nuevo balón de baloncesto inteligente fabricado en Europa

La NBA está experimentando con un balón de baloncesto inteligente fabricado por SportIQ, una startup finlandesa que desarrolla sistemas de sensores para el deporte.

Consigue 50 $ de descuento en una suscripción de un año a Peacock con este código

Una suscripción anual a Peacock de la NBC suele costar 80 dólares, pero sólo tendrás que pagar unos muy asequibles 30 dólares para acceder al servicio de streaming utilizando un código.

Consigue 50 $ de descuento en una suscripción de un año a Peacock con este código

Una suscripción anual a Peacock de la NBC suele costar 80 dólares, pero sólo tendrás que pagar unos muy asequibles 30 dólares para acceder al servicio de streaming utilizando un código.

La detección de deepfakes mejora al usar algoritmos más conscientes de la diversidad demográfica

El software de detección de deepfakes puede atacar injustamente a personas de algunos grupos. Los investigadores intentaron atajar este problema.