Esperto rivela i telefoni AI fan hanno bisogno di spingere Gemini & ChatGPT al limite

Una delle tendenze più ovvie — e onestamente, le più noiose —nel settore degli smartphone negli ultimi due anni è stata l'incessante parlare di esperienze di intelligenza artificiale. I Silicon warriors, in particolare, spesso pubblicizzavano come il loro ultimo processore mobile avrebbe consentito processi AI su dispositivo come la generazione di video.

Ci siamo già, anche se non del tutto. In mezzo a tutto lo spettacolo hype con trucchi AI hit-and-miss per gli utenti di smartphone, il dibattito non è andato quasi mai oltre le presentazioni sfarzose sui nuovi processori e chatbot in continua evoluzione.

È stato solo quando l'assenza di Gemini Nano sul Google Pixel 8 ha sollevato le sopracciglia che le masse sono venute a sapere dell'importanza fondamentale della capacità RAM per l'intelligenza artificiale sui dispositivi mobili. Presto, Apple ha anche chiarito che stava mantenendo l'intelligenza di Apple bloccata su dispositivi con almeno 8 GB di RAM.

Ma l'immagine "telefono AI" non riguarda solo la capacità di memoria. Quanto bene il tuo telefono può eseguire attività basate sull'intelligenza artificiale dipende anche dalle ottimizzazioni della RAM invisibile e dai moduli di archiviazione. E no, non sto parlando solo della capacità.

Le innovazioni della memoria si dirigono verso i telefoni AI

Micron / Tendenze digitali

Digital Trends ha collaborato con Micron, leader globale nelle soluzioni di memoria e storage, per abbattere il ruolo della RAM e dello storage per i processi di intelligenza artificiale sugli smartphone. I progressi fatti da Micron dovrebbero essere sul tuo radar la prossima volta che vai a fare shopping per un telefono di alto livello.

L'ultima novità della società con sede in Idaho include i moduli G9 NAND mobile UFS 4.1 storage e 1γ (1-gamma) LPDDR5X RAM per smartphone di punta. Quindi, in che modo esattamente queste soluzioni di memoria spingono la causa dell'IA sugli smartphone, oltre ad aumentare la capacità?

Iniziamo con la soluzione di archiviazione G9 NAND UFS 4.1. La promessa generale è un consumo energetico frugale, una latenza inferiore e un'elevata larghezza di banda. Lo standard UFS 4.1 può raggiungere velocità di lettura e scrittura sequenziali di picco di 4100 MBps, che equivale a un guadagno del 15% rispetto alla generazione UFS 4.0, riducendo anche i numeri di latenza.

Un altro vantaggio cruciale è che i moduli di storage mobile di nuova generazione di Micron arrivano fino a 2 TB di capacità. Inoltre, Micron è riuscito a ridurne le dimensioni, rendendoli una soluzione ideale per telefoni pieghevoli e telefoni slim di nuova generazione come il Samsung Galaxy S25 Edge.

Micron / Tendenze digitali

Passando al progresso RAM, Micron ha sviluppato quello che chiama 1γ LPDDR5X moduli RAM. Offrono una velocità di picco di 9200 MT / s, possono contenere il 30% in più di transistor a causa della riduzione delle dimensioni e consumano il 20% di potenza inferiore. Micron ha già servito la soluzione RAM 1β (1-beta) leggermente più lenta confezionata all'interno degli smartphone della serie Samsung Galaxy S25.

L'interazione tra storage e AI

Ben Rivera, direttore del marketing di prodotto nella Mobile Business Unit di Micron, mi dice che Micron ha apportato quattro miglioramenti cruciali in cima alle sue ultime soluzioni di storage per garantire operazioni di IA più veloci sui dispositivi mobili. Includono UFS suddivisi in zone, deframmentazione dei dati, WriteBooster appuntato e Intelligent Latency Tracker.

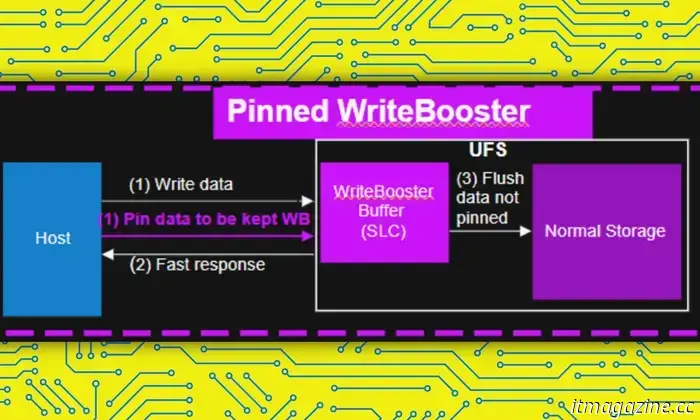

"Questa funzione consente al processore o all'host di identificare e isolare o" bloccare” i dati più frequentemente utilizzati da uno smartphone in un'area del dispositivo di archiviazione chiamata buffer WriteBooster (simile a una cache) per consentire un accesso rapido e veloce", spiega Rivera.

Micron / Tendenze digitali

Ogni modello di intelligenza artificiale-pensate a Google Gemini o ChatGPT-che cerca di eseguire attività sul dispositivo ha bisogno di un proprio set di file di istruzioni che vengono memorizzati localmente su un dispositivo mobile. Apple Intelligence, ad esempio, ha bisogno di 7 GB di spazio di archiviazione per tutti i suoi imbrogli.

Per eseguire un'attività, non è possibile delegare l'intero pacchetto AI alla RAM, perché avrebbe bisogno di spazio per gestire altre faccende critiche come chiamare o interagire con altre app importanti. Per gestire il vincolo sul modulo di archiviazione Micron, viene creata una mappa di memoria che carica solo i pesi AI necessari dallo storage e sulla RAM.

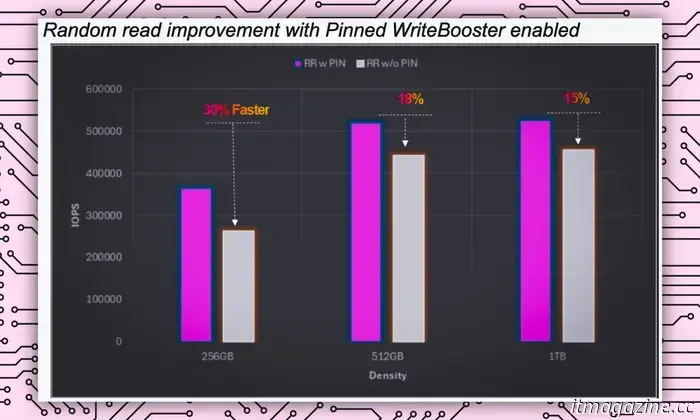

Quando le risorse si restringono, ciò di cui hai bisogno è uno scambio e una lettura dei dati più veloci. In questo modo si assicura che le attività AI vengano eseguite senza influire sulla velocità di altre attività importanti. Grazie a Pinned WriteBooster, questo scambio di dati è accelerato del 30%, garantendo che le attività di IA vengano gestite senza ritardi.

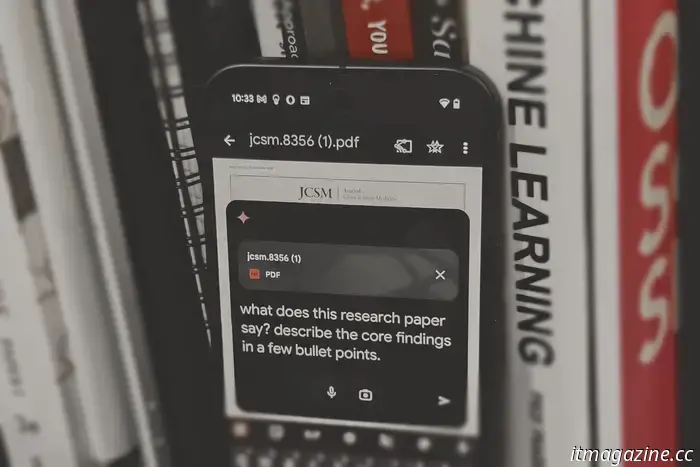

Quindi, diciamo che hai bisogno di Gemini per estrarre un PDF per l'analisi. Il fast memory swap assicura che i pesi AI necessari vengano rapidamente spostati dallo storage al modulo RAM.

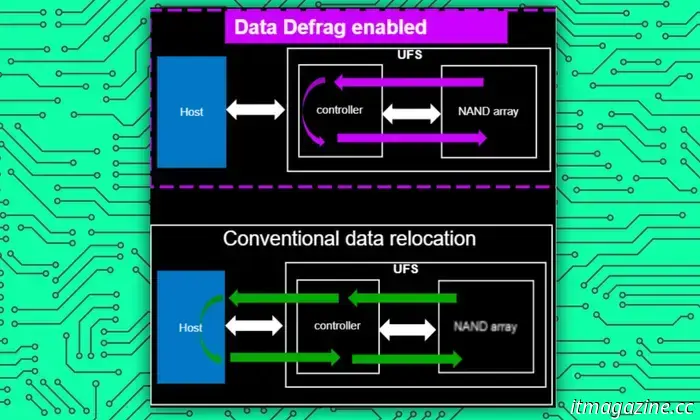

Successivamente, abbiamo Deframmentazione dei dati. Pensalo come una scrivania o un organizzatore almirah, uno che assicura che gli oggetti siano raggruppati ordinatamente in diverse categorie e collocati nei loro armadi unici in modo che sia facile trovarli.

Micron / Tendenze digitali

Nel contesto degli smartphone, poiché più dati vengono salvati per un lungo periodo di utilizzo, tutti vengono solitamente archiviati in modo piuttosto casuale. L'impatto netto è che quando il sistema di bordo ha bisogno di accedere a un certo tipo di file, diventa più difficile trovarli tutti, portando a un funzionamento più lento.

Secondo Rivera, Data Defrag non solo aiuta con l'archiviazione ordinata dei dati, ma cambia anche il percorso di interazione tra lo storage e il controller del dispositivo. In tal modo, migliora la velocità di lettura dei dati di un impressionante 60%, che naturalmente accelera tutti i tipi di interazioni utente-macchina, compresi i flussi di lavoro AI.

"Questa funzione può aiutare ad accelerare le funzionalità di intelligenza artificiale come quando un modello di intelligenza artificiale generativo, come quello utilizzato per generare un'immagine da un prompt di testo, viene chiamato dallo storage alla memoria, consentendo ai dati di essere letti più velocemente dallo storage alla memoria”, ha detto il dirigente di Micron a Digital Trends.

Intelligence Latency Tracker è un'altra caratteristica che tiene essenzialmente d'occhio gli eventi di ritardo e i fattori che potrebbero rallentare il ritmo abituale del telefono. Successivamente aiuta con il debug e l'ottimizzazione delle prestazioni del telefono per garantire che le attività regolari e AI non incappino in dossi.

Micron / Tendenze digitali

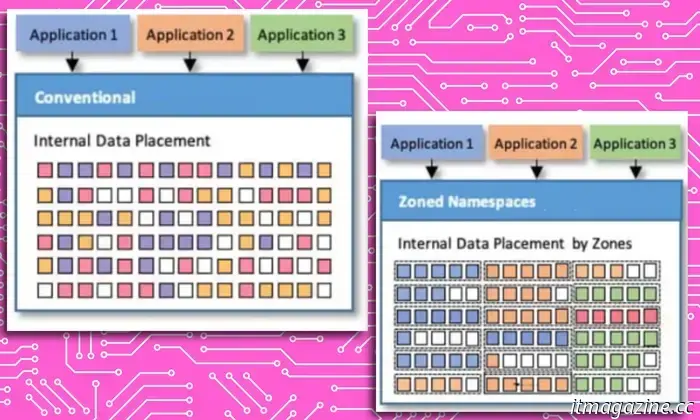

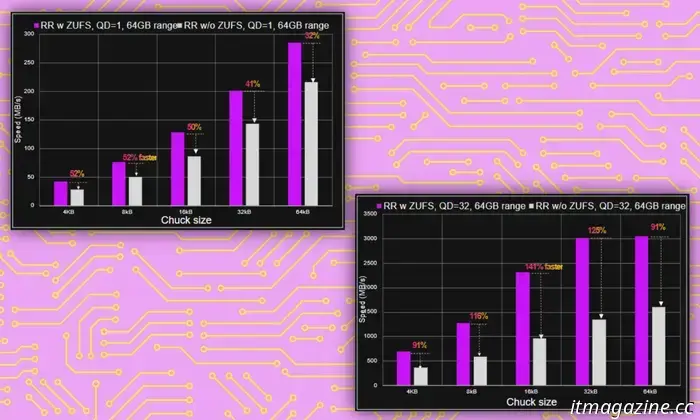

Il miglioramento dello storage finale è zonato UFS. Questo sistema garantisce che i dati con natura I/O simile siano archiviati in modo ordinato. Questo è fondamentale perché rende più facile per il sistema per individuare i file necessari, invece di perdere tempo rovistando tra tutte le cartelle e le directory.

"La funzione ZUFS di Micron aiuta a organizzare i dati in modo che quando il sistema ha bisogno di individuare dati specifici per un'attività, sia un processo più veloce e fluido”, ci ha detto Rivera.

Oltre la capacità della RAM

Quando si tratta di flussi di lavoro AI, è necessaria una certa quantità di RAM. Più, meglio è. Mentre Apple ha fissato la base a 8 GB per il suo stack di intelligenza di Apple, i giocatori dell'ecosistema Android sono passati a 12 GB come default sicuro. Perché così?

"Le esperienze di intelligenza artificiale sono anche estremamente ricche di dati e quindi assetate di potere. Quindi, al fine di mantenere la promessa dell'IA, la memoria e lo storage devono offrire bassa latenza e prestazioni elevate con la massima efficienza energetica”, spiega Rivera.

Con la sua soluzione RAM 1γ (1-gamma) LPDDR5X di nuova generazione per smartphone, Micron è riuscita a ridurre la tensione operativa dei moduli di memoria. Poi c'è la questione fin troppo importante delle prestazioni locali. Rivera afferma che i nuovi moduli di memoria possono ronzare fino a 9,6 gigabit al secondo, garantendo prestazioni AI di prim'ordine.

Micron / Tendenze digitali

Micron afferma che i miglioramenti nel processo di litografia ultravioletta estrema (EUV) hanno aperto le porte non solo a velocità più elevate, ma anche a un sano salto del 20% nell'efficienza energetica.

La strada verso esperienze AI più private?

Le soluzioni di RAM e storage di nuova generazione di Micron per smartphone sono mirate non solo a migliorare le prestazioni dell'IA, ma anche il ritmo generale delle attività quotidiane degli smartphone. Ero curioso di sapere se lo storage G9 NAND mobile UFS 4.1 e i miglioramenti della RAM 1γ (1-gamma) LPDDR5X avrebbero anche accelerato i processori AI offline.

I produttori di smartphone e i laboratori di intelligenza artificiale si stanno spostando sempre più verso l'elaborazione locale dell'intelligenza artificiale. Ciò significa che invece di inviare le query a un server cloud in cui viene gestita l'operazione e quindi il risultato viene inviato al telefono tramite una connessione Internet, l'intero flusso di lavoro viene eseguito localmente sul telefono.

Nadeem Sarwar / Tendenze digitali

Dalla trascrizione di chiamate e note vocali all'elaborazione del tuo complesso materiale di ricerca in file PDF, tutto accade sul tuo telefono e nessun dato personale lascia mai il tuo dispositivo. È un approccio più sicuro che è anche più veloce, ma allo stesso tempo richiede risorse di sistema robuste. Un modulo di memoria più veloce ed efficiente è uno di questi prerequisiti.

Le soluzioni next-gen di Micron possono aiutare con l'elaborazione locale dell'IA? Può. In effetti, accelererà anche i processi che richiedono una connessione cloud, come la generazione di video utilizzando il modello Veo di Google, che richiedono ancora potenti server di calcolo.

"Un'app AI nativa in esecuzione direttamente sul dispositivo avrebbe il maggior traffico dati poiché non solo legge i dati degli utenti dal dispositivo di archiviazione, ma sta anche conducendo inferenze AI sul dispositivo. In questo caso, le nostre funzionalità aiuterebbero a ottimizzare il flusso di dati per entrambi", mi dice Rivera.

Quindi, quanto presto puoi aspettarti che i telefoni dotati delle ultime soluzioni Micron atterrino sugli scaffali? Rivera afferma che tutti i principali produttori di smartphone adotteranno i moduli RAM e storage di nuova generazione di Micron. Per quanto riguarda l'arrivo sul mercato, " i modelli di punta che verranno lanciati alla fine del 2025 o all'inizio del 2026” dovrebbero essere sul radar dello shopping.

Altri articoli

Le CPU Intel Nova Lake potrebbero richiedere nuove schede madri con socket LGA 1954

Le CPU desktop next-gen di Intel dovrebbero passare a un nuovo socket

Le CPU Intel Nova Lake potrebbero richiedere nuove schede madri con socket LGA 1954

Le CPU desktop next-gen di Intel dovrebbero passare a un nuovo socket

Samsung sta usando l'intelligenza artificiale per prevedere la rottura negli elettrodomestici, ma c'è un problema

Samsung sta infondendo l'intelligenza artificiale in un'intera gamma di prodotti, compresi i suoi elettrodomestici. In precedenza ti abbiamo portato le novità dell'intelligenza artificiale nelle lavatrici Samsung e nel suo Jet Ultra su misura, ma l'azienda sta anche utilizzando l'intelligenza artificiale per monitorare i tuoi elettrodomestici per prevedere se ci sarà un guasto. […]

Samsung sta usando l'intelligenza artificiale per prevedere la rottura negli elettrodomestici, ma c'è un problema

Samsung sta infondendo l'intelligenza artificiale in un'intera gamma di prodotti, compresi i suoi elettrodomestici. In precedenza ti abbiamo portato le novità dell'intelligenza artificiale nelle lavatrici Samsung e nel suo Jet Ultra su misura, ma l'azienda sta anche utilizzando l'intelligenza artificiale per monitorare i tuoi elettrodomestici per prevedere se ci sarà un guasto. […]

Brett Goldstein equipara Ted Lasso stagione 4 con riportare in vita un gatto

È possibile ottenere vibrazioni Sematary Pet dal modo in cui Brett Goldstein parla Ted Lasso stagione 4.

Brett Goldstein equipara Ted Lasso stagione 4 con riportare in vita un gatto

È possibile ottenere vibrazioni Sematary Pet dal modo in cui Brett Goldstein parla Ted Lasso stagione 4.

Fatal Fury: City of the Wolves: un ultimo show a South Town

Fatal Fury: City of the Wolves è un gioco di combattimento forte, ma che si sente un po ' creativamente compromesso dai rapporti commerciali che lo alimentano.

Fatal Fury: City of the Wolves: un ultimo show a South Town

Fatal Fury: City of the Wolves è un gioco di combattimento forte, ma che si sente un po ' creativamente compromesso dai rapporti commerciali che lo alimentano.

NYT Cruciverba: risposte per Lunedi, aprile 21

Il cruciverba del New York Times può essere difficile, anche se non è il numero di domenica! Se sei bloccato, siamo qui per aiutarti con gli indizi e le risposte di oggi.

NYT Cruciverba: risposte per Lunedi, aprile 21

Il cruciverba del New York Times può essere difficile, anche se non è il numero di domenica! Se sei bloccato, siamo qui per aiutarti con gli indizi e le risposte di oggi.

L'ultimo monitor intelligente di LG può rotolare su ruote, ma ha bisogno di una spina di alimentazione

Lo Smart Monitor Swing è dotato di un supporto dedicato con ruote integrate

L'ultimo monitor intelligente di LG può rotolare su ruote, ma ha bisogno di una spina di alimentazione

Lo Smart Monitor Swing è dotato di un supporto dedicato con ruote integrate

Esperto rivela i telefoni AI fan hanno bisogno di spingere Gemini & ChatGPT al limite

Un dirigente di Micron spiega in dettaglio come i miglioramenti alla RAM e alla tecnologia di archiviazione velocizzeranno le operazioni di intelligenza artificiale sugli smartphone di nuova generazione in arrivo sul mercato.