lo siento, no lo he entendido": La IA malinterpreta las palabras de algunas personas más que otras

La idea de un asistente de inteligencia artificial parecido a un ser humano con el que se puede hablar ha estado viva en la imaginación de muchas personas desde el estreno de "Her", la película de Spike Jonze de 2013 sobre un hombre que se enamora de una IA parecida a Siri llamada Samantha. En el transcurso de la película, el protagonista se enfrenta a las formas en que Samantha, por muy real que parezca, no es y nunca será humana. Doce años después, esto ya no es material de ciencia ficción. Herramientas de IA generativa como ChatGPT y asistentes digitales como Siri, de Apple, y Alexa, de Amazon, ayudan a la gente a obtener indicaciones para llegar a su destino, hacer listas de la compra y muchas otras cosas. Pero, al igual que Samantha, los sistemas automáticos de reconocimiento de voz no pueden hacer todo lo que hace un oyente humano. Probablemente hayas tenido la frustrante experiencia de llamar a tu banco o compañía de servicios públicos y tener que repetir lo que dices para que el robot digital de atención al cliente de la otra línea te entienda. Los investigadores en lingüística e informática han demostrado que estos sistemas funcionan peor para unas personas que para otras. Tienden a cometer más errores si tienes un acento no nativo o regional, eres negro, hablas en inglés vernáculo afroamericano, cambias de código, si eres mujer, eres mayor, demasiado joven o tienes algún impedimento en el habla. Oído de lata A diferencia de ti o de mí, los sistemas de reconocimiento automático del habla no son lo que los investigadores llaman "oyentes comprensivos" En lugar de intentar entenderle con otras pistas útiles, como la entonación o los gestos faciales, se dan por vencidos. Como las empresas y los organismos públicos adoptan cada vez más herramientas de reconocimiento automático del habla para reducir costes, la gente no tiene más remedio que interactuar con ellas. Pero cuanto más se utilicen estos sistemas en campos críticos, que van desde los primeros auxilios y la atención sanitaria hasta la educación y el cumplimiento de la ley, más probable será que haya graves consecuencias cuando no reconozcan lo que dice la gente. Imagínese que en algún momento del futuro próximo resulta herido en un accidente de coche. Llamas al 911 para pedir ayuda, pero en lugar de comunicarte con un operador humano, te atiende un robot diseñado para descartar las llamadas que no son de emergencia. Tardan varias rondas en entenderte, haciéndote perder tiempo y elevando tu nivel de ansiedad en el peor momento. ¿Qué provoca este tipo de errores? Algunas de las desigualdades que provocan estos sistemas se encuentran en los montones de datos lingüísticos que los desarrolladores utilizan para crear grandes modelos lingüísticos. Los desarrolladores entrenan a los sistemas de inteligencia artificial para que entiendan e imiten el lenguaje humano alimentándolos con grandes cantidades de texto y archivos de audio que contienen habla humana real. Pero, ¿de quién es el habla que reciben? Si un sistema obtiene altos índices de precisión cuando habla con estadounidenses blancos acomodados de unos 30 años, es razonable suponer que se ha entrenado utilizando un montón de grabaciones de audio de personas que encajan en este perfil. Con una recopilación rigurosa de datos procedentes de diversas fuentes, los desarrolladores de IA podrían reducir estos errores. Pero crear sistemas de IA capaces de entender las infinitas variaciones del habla humana derivadas de factores como el sexo, la edad, la raza, la primera o la segunda lengua, el estatus socioeconómico, la capacidad y muchos otros, requiere recursos y tiempo considerables. Inglés "correcto" Para las personas que no hablan inglés -es decir, la mayoría de la población mundial- los retos son aún mayores. La mayoría de los sistemas de IA generativa más importantes del mundo se crearon en inglés y funcionan mucho mejor en este idioma que en cualquier otro. Sobre el papel, la IA tiene un gran potencial cívico para la traducción y el aumento del acceso de las personas a la información en diferentes idiomas, pero por ahora, la mayoría de los idiomas tienen una huella digital más pequeña, lo que hace difícil que puedan alimentar grandes modelos lingüísticos. Incluso dentro de los idiomas bien servidos por grandes modelos lingüísticos, como el inglés y el español, su experiencia varía dependiendo del dialecto del idioma que hable. En este momento, la mayoría de los sistemas de reconocimiento de voz y chatbots de IA generativa reflejan los sesgos lingüísticos de los conjuntos de datos en los que se entrenan. De hecho, se ha demostrado que la IA "aplana" la diversidad lingüística. Ahora hay empresas emergentes de IA que ofrecen borrar los acentos de sus usuarios, partiendo de la base de que su clientela principal serían los proveedores de servicios de atención al cliente con centros de llamadas en países extranjeros como India o Filipinas. Esta oferta perpetúa la noción de que algunos acentos son menos válidos que otros. Es de suponer que la IA de conexión humana mejorará en el procesamiento del lenguaje, teniendo en cuenta variables como los acentos, el cambio de código y similares. En Estados Unidos, la ley federal obliga a los servicios públicos a garantizar un acceso equitativo a los servicios, independientemente de la lengua que hable una persona. Muchas personas prefieren hablar con una persona de carne y hueso cuando preguntan sobre una factura o un problema médico, o al menos tener la posibilidad de no interactuar con sistemas automatizados cuando buscan servicios clave. Esto no quiere decir que en la comunicación interpersonal nunca se produzcan errores de comunicación, pero cuando se habla con una persona real, ésta está preparada para escuchar con simpatía. Con la IA, al menos por ahora, o funciona o no funciona. Si el sistema es capaz de procesar lo que se le dice, no hay problema. Roberto Rey Agudo, Profesor Asistente de Investigación de Español y Portugués, Dartmouth College Este artículo ha sido publicado por The Conversation bajo una licencia Creative Commons. Lee el artículo original. Recibe el boletín de TNW Recibe las noticias tecnológicas más importantes en tu bandeja de entrada cada semana. También etiquetado con

Otros artículos

¿Otro asistente de inteligencia artificial para iPhone? Este es diferente

Le Chat es el último chatbot de inteligencia artificial que ha llegado al iPhone. Esto es lo que puede hacer.

¿Otro asistente de inteligencia artificial para iPhone? Este es diferente

Le Chat es el último chatbot de inteligencia artificial que ha llegado al iPhone. Esto es lo que puede hacer.

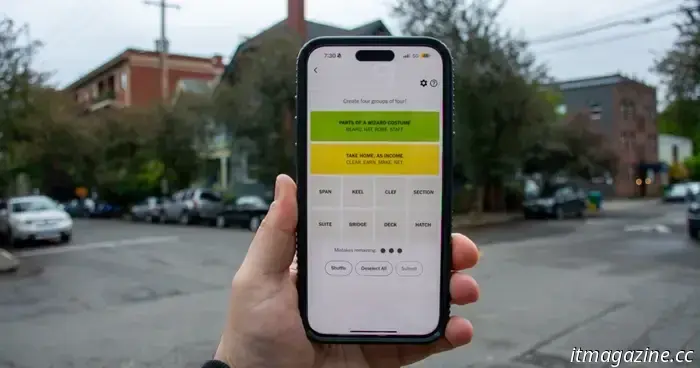

NYT Strands hoy: pistas, spangramas y respuestas para el viernes 7 de febrero

Strands es una versión complicada de la clásica sopa de letras de NYT Games. Si estás atascado y no puedes resolver la sopa de letras de hoy, aquí encontrarás ayuda y pistas.

NYT Strands hoy: pistas, spangramas y respuestas para el viernes 7 de febrero

Strands es una versión complicada de la clásica sopa de letras de NYT Games. Si estás atascado y no puedes resolver la sopa de letras de hoy, aquí encontrarás ayuda y pistas.

NYT Connections: pistas y respuestas para el viernes 7 de febrero

Connections es el nuevo juego de puzzle del New York Times, y puede resultar bastante difícil. Si necesitas que te echemos una mano para resolver el puzle de hoy, estamos aquí para ayudarte.

NYT Connections: pistas y respuestas para el viernes 7 de febrero

Connections es el nuevo juego de puzzle del New York Times, y puede resultar bastante difícil. Si necesitas que te echemos una mano para resolver el puzle de hoy, estamos aquí para ayudarte.

Google Mensajes podría permitirte deshacer el envío de mensajes incómodos en los chats RCS

Los Mensajes de Google podrían recibir una función de "borrado para todos", que permitiría recuperar mensajes, pero sólo en chats habilitados para RCS.

Google Mensajes podría permitirte deshacer el envío de mensajes incómodos en los chats RCS

Los Mensajes de Google podrían recibir una función de "borrado para todos", que permitiría recuperar mensajes, pero sólo en chats habilitados para RCS.

3 comedias románticas en Amazon Prime Video que tienes que ver en febrero de 2025

Acurrúcate con una de estas tres comedias románticas en Amazon Prime Video que tienes que ver en febrero de 2025, todas perfectas para San Valentín.

3 comedias románticas en Amazon Prime Video que tienes que ver en febrero de 2025

Acurrúcate con una de estas tres comedias románticas en Amazon Prime Video que tienes que ver en febrero de 2025, todas perfectas para San Valentín.

¿Nuevo iPad Air? Hay un aviso de pocas existencias

El próximo iPad Air podría desvelarse en pocas semanas.

¿Nuevo iPad Air? Hay un aviso de pocas existencias

El próximo iPad Air podría desvelarse en pocas semanas.

lo siento, no lo he entendido": La IA malinterpreta las palabras de algunas personas más que otras

Según nuevos estudios, los sistemas de reconocimiento de voz son menos precisos para las mujeres y los negros, entre otros grupos demográficos.